AI数理は Minecraftの夢を見る?

みなさまこんにちは、(株) Qualiteg 研究部です。

LLM関連の論文を読んでいると、なぞの数式、なぞの記号がたくさんでてきて、めまいがすることはないでしょうか?

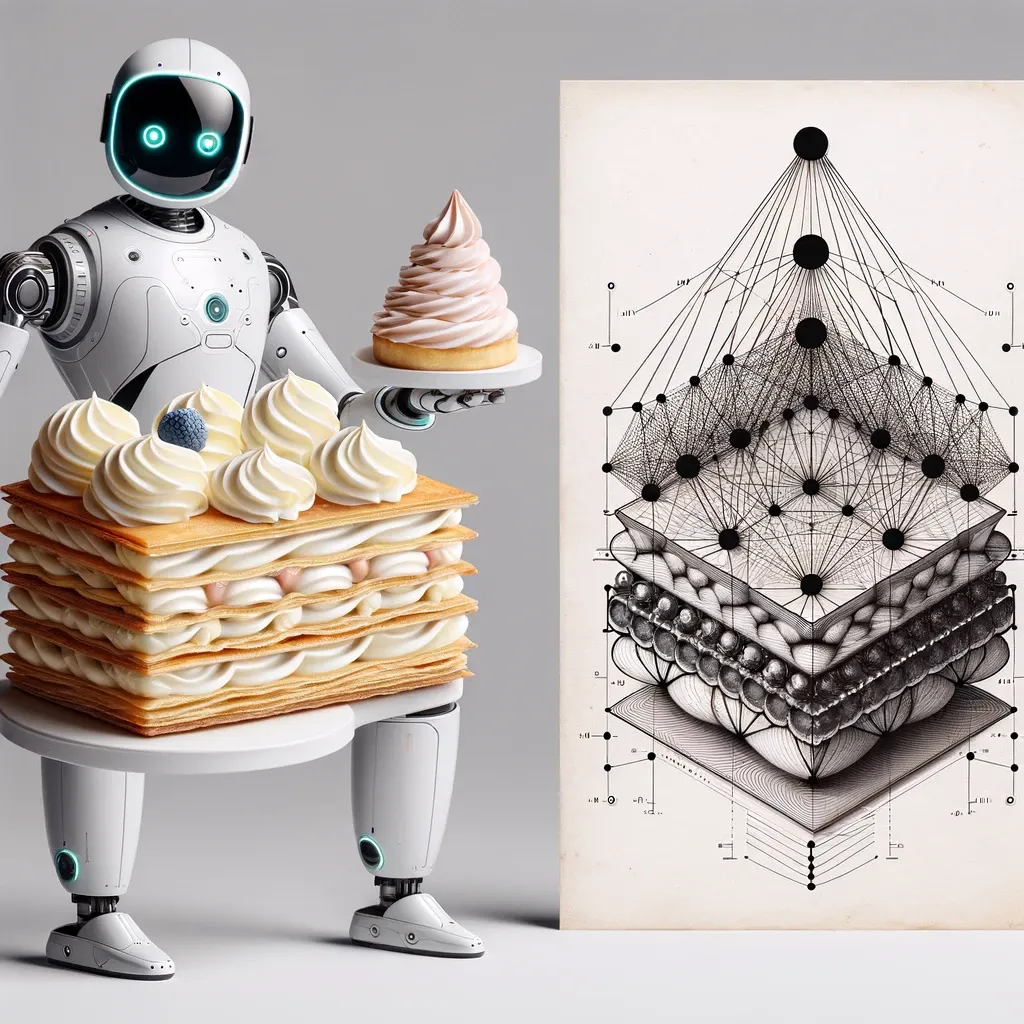

私も学生時代ニューラルネットを研究していましたが、それを理解するための数学的背景がミルフィーユのように多層になっており、面食らった記憶があります。

現代のLLMは、パーセプトロンや初期のニューラルネットの研究にくらべると、いや、分析系のディープラーニングベースAIの頃からみてもミルフィーユの層が10倍くらい厚く、LLMの仕組みを数学的に理解するには、その何重、何百という数学的理論基盤を理解しなければいけません。

(LLMを利用するだけなら、ミルフィーユをまるごと食べて「おいし~」って言っている状態ですが、じゃあ、その多層(の数理)になったミルフィーユを1層ずつ理解しながら作っていくのは食べるのにくらべてどれだけ大変か、ですね。)

このように、LLMの実現には、機械学習の基礎編としての確率統計の話や、クラシックな機械学習の理論から、ディープラーニングで使う微分や離散化、RNN,LSTMなどを経てそこからトランスフォーマー、アテンションときてBertへの流れ。BertからいわゆるGPTへと、多くの先人、偉人、先輩方のたゆまぬ努力による数学的な理論体系が積み重なって実現しております。

そうした理論体系は一朝一夕でマスターできるものではありませんが、数年間学んでみて共通の重要な数学的基礎は存在しているように思えます。

そこで、私たちは Qualiteg ブログでそうした数学的土台となる部分をわかりやすくお伝えしていければいいなとおもい、AI数理シリーズと題して投稿を開始してみようとおもいます。

ということで本シリーズの目的はざっくりいうと、「arXiv の論文で出てくる数式の手触り感を得たい」というところかとおもいます。

数式や数学は慣れてくると、Minecraft のブロックのように見えてきます。吸着ピストンとリピーターとコンパレータをこうやっておいて、レッドストーン回路をこう組むと、フリップフロップ作れるねー、という感覚に近いです。(私だけかもしれません)

読者のみなさまが本シリーズを読んだ後、数式や公式がMinecraft のブロックに見えてきたら幸いです😄

navigation