[自作日記12] グラボをマザーボードに装着!

![[自作日記12] グラボをマザーボードに装着!](/content/images/size/w1200/2024/04/gpu_machine_jisaku_12.png)

今回は、いよいよ、主役のグラフィックボードを装着します!

1.PCI Express スロットのカバーをはずす

グラフィックボードを挿入するのは PCI Express gen 5 x16 スロットなので、その部分のカバーをはずします。

また、今回のグラフィックボードは 4 スロット占有なのでそこから4スロット分のカバーをはずしておきます。

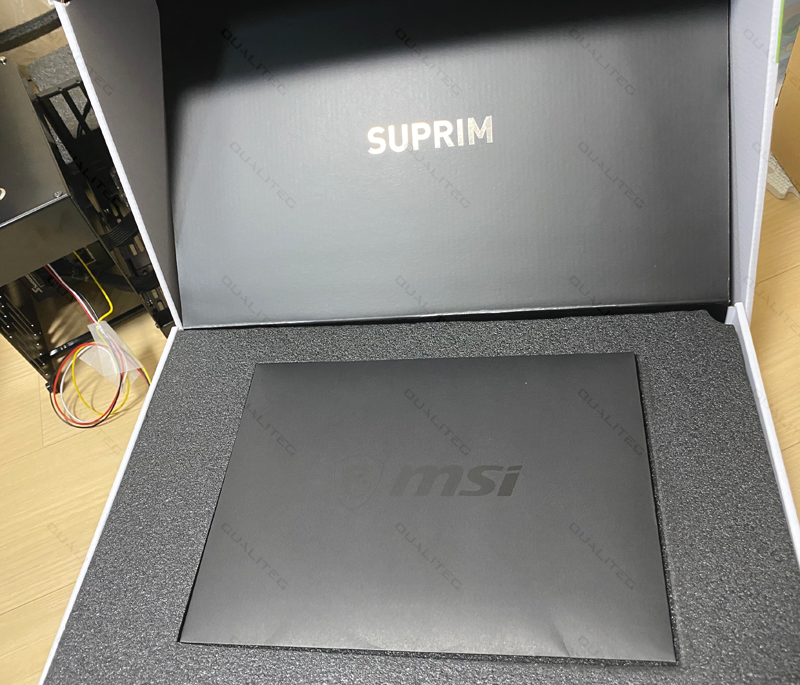

2.グラフィックボードを開梱する

今回のパーツでもっとも高価だったグラボをいよいよ開梱しましょう!

おおおグラボ本体と、支え用のアームが入っています。

袋からとりだすと、34センチのビッグサイズの MSI SUPRIM X GeForce RTX 3090 Tiがお目見え!

ヒートシンクがすごいですね。

こちらら側は、3連装のプロペラファンです。MSIのドラゴンマークがかっこいいです。

コンシューマー用グラボは見た目もかっこいいですね。

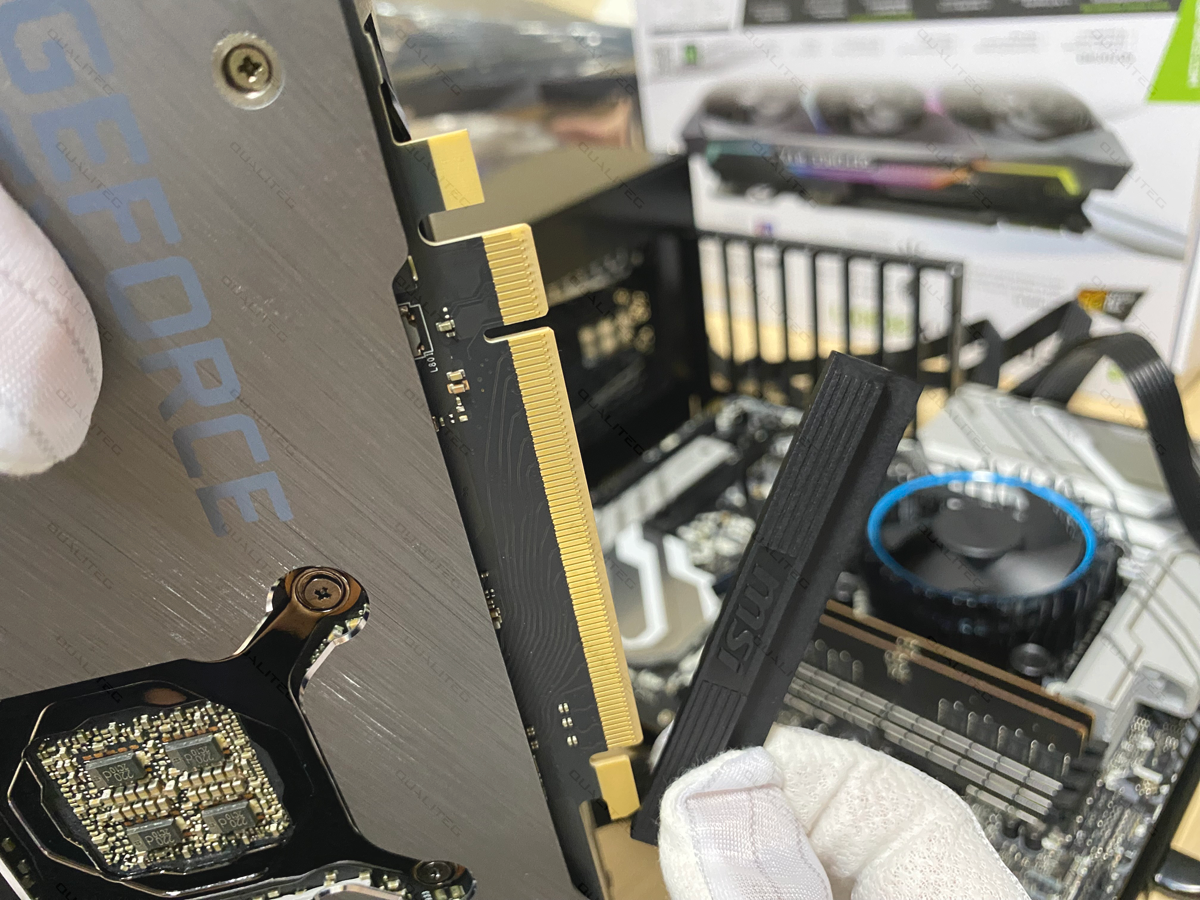

さて、さっそく、このグラフィックボードを、PCI Express スロットに装着するんですが、端子部分に実はカバーがかかっていますので、

まず、そのカバーを外します。

端子カバーをはずしたら、丁寧に、PCI Express x16 スロットに差し込みます。

挿し込んだらしっかりねじ止めします。

これで無事にGPUまで装着できました!

次回は、給電ケーブル類を電源装置に接続していきます!

navigation