[自作日記13] 電源ケーブルの結線

![[自作日記13] 電源ケーブルの結線](/content/images/size/w1200/2024/04/gpu_machine_jisaku_13.png)

さて、そろそろ組み立ても終盤です!がんばりましょう!

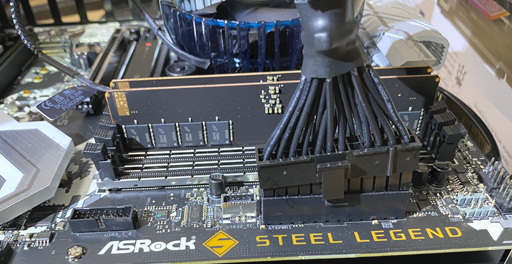

1.マザーボード用給電ケーブルを挿す

24ピンATXケーブルというもっともたくさん束ねられているケーブルがありますので、まずはそれを電源側の M/B 表記のところに挿し込みます

次に同ケーブルをマザーボード側に挿します。

しっかりツメがかみ合うように装着します

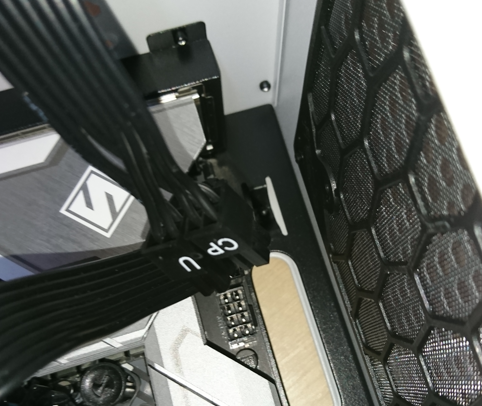

2.CPUへの給電ケーブルを挿す

次はCPUケーブルです。通常6ピン+2ピンの構成になっており、こちらも電源側とマザーボード側双方に装着します。

まず電源側の CPU/PCI-E と表示のあるところに、片一方を挿します

続いてマザーボード側にも挿しましょう。

しっかりと挿さりました

マザーボード表面に CPU PWR1,CPU PWR2 と書いてある場合もあれば、 ATX12V1,ATX12V2 とだけ書いてある場合などがあります。メーカーによって表記が異なります。

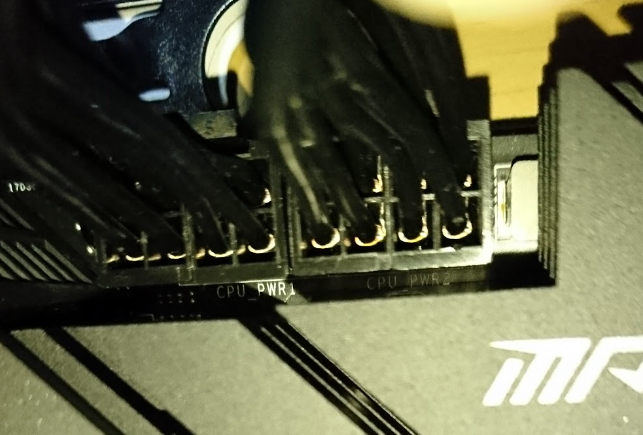

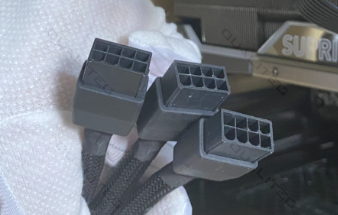

3.グラフィックボード用の給電ケーブルを挿す

グラボの種類にもよりますが、大型グラボは多くの電力を必要とします。今回のグラフィックボードは 3系統のPCI電源が必要となるため、グラボ側は 3 in 1 スタイルのたこ足PCI電源ケーブルになっています。

まずのたこあしPCIケーブルメス側をGPUの外部給電コネクタに挿します

反対側はこんなふうに3股になっていますね

これで、グラボの3股たこあし給電コネクタが接続できたので

こんどは、電源側につなぐ3股たこあし給電ケーブルをもってきましょう。

こんなふうにオス型のPCIe給電コネクタが3つ必要になります。

これらをそれぞれ接続すると、こんなふうになります

次はこの3本のPCIe給電ケーブルを電源ユニット側に接続しましょう

はい、このように PCI-E 側に接続すれば、グラボへの給電もバッチリです。

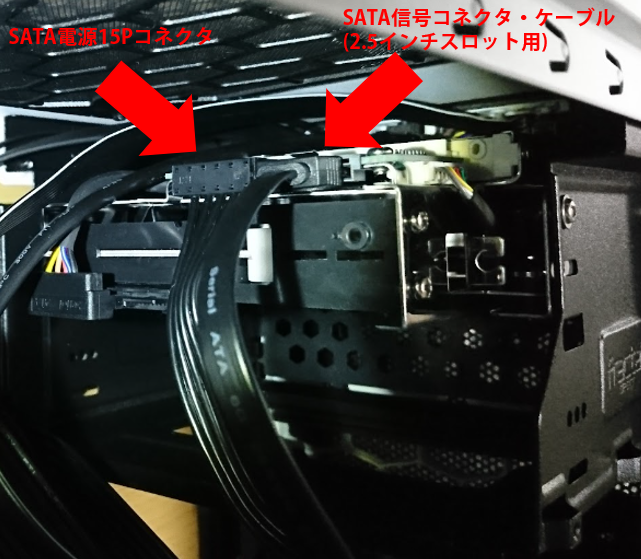

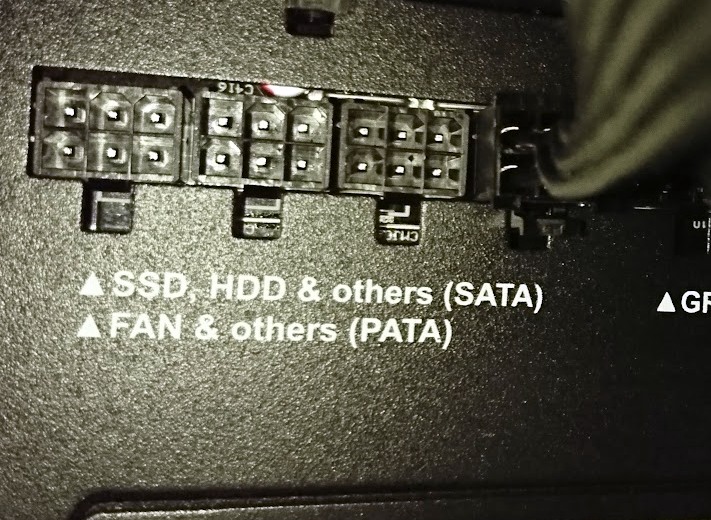

4.SATA電源ケーブルを挿す

さいごに、SATA用の電源ケーブルを挿しましょう。

私はデュアルブートのために、M.2のSSDとは別に2.5インチSATAドライブを使います。そのSATAは取り換え可能にするという野望があるので、5インチベイに入れたSATAリムーバルケースを設置しました。

今接続する電源ケーブルはそのためのもので、リムーバルケースからの電源ケーブルのうち、2.5インチのSATA電源ケーブルと電源ユニットを接続します。

電源側

これで、すべての結線がおわりました!

あとは、ケースのフタ類をねじ止めして完成です!

組立編はここまでです!

おつきあいありがとうございました。秋葉原で調達してきたパーツが、いま1台のパソコンとして組みあがりました。自分で組み立てるとほんとうに愛着がわきますね。

さて、次回からは、このGPUマシンをAIマシンにすべく、OSやAI関連ソフトウェアの導入までを行う ソフトウェアインストール編 を開始したいとおもいます!

navigation