日々の開発Tips

WSL2でDNS解決がうまくいかない問題と解決方法

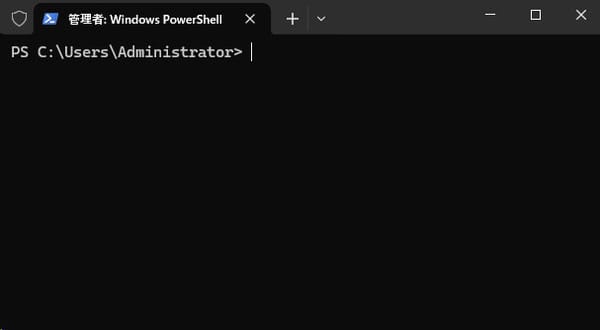

こんにちは! Windows Subsystem for Linux (WSL2)は、Windows上でLinux環境を利用できる素晴らしい機能ですが、中にはDNS解決に関する問題が発生することがあります。この記事では、その症状と効果的な解決方法を紹介します。 検証環境 この記事で紹介する方法は、以下のバージョンで検証しています WSL バージョン: 2.4.13.0 カーネル バージョン: 5.15.167.4-1 WSLg バージョン: 1.0.65 MSRDC バージョン: 1.2.5716 Direct3D バージョン: 1.611.1-81528511 DXCore バージョン: 10.0.26100.1-240331-1435.ge-release Windows バージョン:

![[vLLM] To use CUDA with multiprocessing, you must use the 'spawn' start method の対処法](https://images.unsplash.com/photo-1597872200969-2b65d56bd16b?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDh8fGdwdXxlbnwwfHx8fDE3MzkyMzYxNTh8MA&ixlib=rb-4.0.3&q=80&w=600)