LLM-Audit

PIIの高精度検出を支える技術~日本語という言語の奥深さに寄り添う~

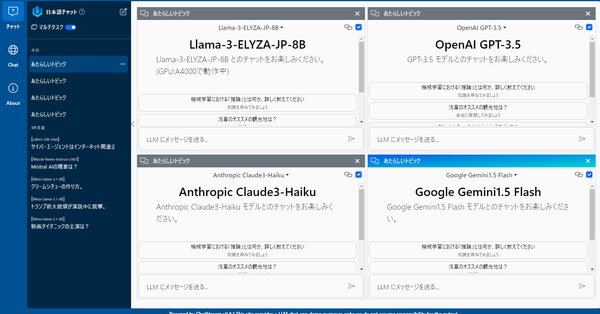

こんにちは、Qualiteg研究部です! 本日はPII(個人識別情報)検出技術について解説いたします。 グローバルツールと日本語特化ツールの共存 個人情報保護は世界共通の課題です。 GDPR、CCPA、そして日本の改正個人情報保護法など、世界中で規制が強化される中、多くの優れたPII(個人識別情報)検出ツールが研究・開発されていますが、日本語を中心としたビジネスシーンで利用しようとすると「おや?」っとなることが多く割と無視できない規模の追加開発、特別対応による追加工数が発生することがあります。なぜなら、それらツールは英語(および英語文化圏)を中心に設計されており、スペック上は日本語も対応言語の1つとして挙げられておりますがきめ細やかな対応が後手にまわることが多いです。 当然ですが言語には固有の文化と構造があり日本語は、その独特な文字体系と文化的背景により、特別なアプローチが必要となるシーンが存在しています。 私たちが開発している日本語特化型PII検出技術は、グローバルに採用されている優れた基盤技術も活かし共存ながら、日本語の特性に深く寄り添うことで、日本企業により実用的なソリュ

![[AI新規事業創出]Qualitegが考える、ビジネスモデル設計でやるべきこと、やってはいけないこと](https://images.unsplash.com/photo-1590098563686-06ab8778a6a7?crop=entropy&cs=tinysrgb&fit=max&fm=jpg&ixid=M3wxMTc3M3wwfDF8c2VhcmNofDZ8fGJ1c2luZXNzJTIwbW9kZWx8ZW58MHx8fHwxNzMzNzQ2NDY3fDA&ixlib=rb-4.0.3&q=80&w=600)